Dalam dunia optimasi mesin pencari (SEO), robots.txt adalah salah satu file penting yang sering kali diabaikan. Padahal, jika digunakan dengan benar, file ini bisa membantu mengarahkan crawler mesin pencari untuk mengindeks halaman yang memang diinginkan dan menghindari halaman yang seharusnya tidak tampil di hasil pencarian. Lalu, Penerapan Robots.txt yang Benar pada Website Sesuai dengan Panduan Google? Berikut ulasan lengkapnya.

Apa Itu Robots.txt?

Robots.txt adalah sebuah file teks sederhana yang ditempatkan di root direktori sebuah website. File ini digunakan untuk memberi instruksi kepada bot mesin pencari tentang halaman atau bagian mana dari situs yang boleh atau tidak boleh di-crawl.

Mesin pencari seperti Googlebot, Bingbot, dan lainnya akan membaca file robots.txt sebelum melakukan proses crawling. Jika ada instruksi untuk tidak mengindeks halaman tertentu, maka bot akan mengikuti perintah tersebut—meskipun ada pengecualian dalam beberapa kasus tertentu.

Mengapa Robots.txt Penting?

Penggunaan robots.txt yang benar dapat memberikan beberapa manfaat bagi sebuah website, di antaranya:

- Menghindari Indexing Halaman yang Tidak Perlu

- Misalnya, halaman login admin atau halaman hasil pencarian internal website yang tidak perlu muncul di Google.

- Menghemat Crawl Budget

- Setiap website memiliki jumlah terbatas dalam hal berapa banyak halaman yang bisa di-crawl oleh Google dalam satu waktu. Dengan menutup halaman yang tidak perlu, bot dapat lebih fokus pada halaman yang lebih penting.

- Menghindari Duplikasi Konten

- Jika ada halaman duplikat atau halaman dengan parameter yang tidak diinginkan, robots.txt bisa membantu untuk mengatur agar tidak di-crawl.

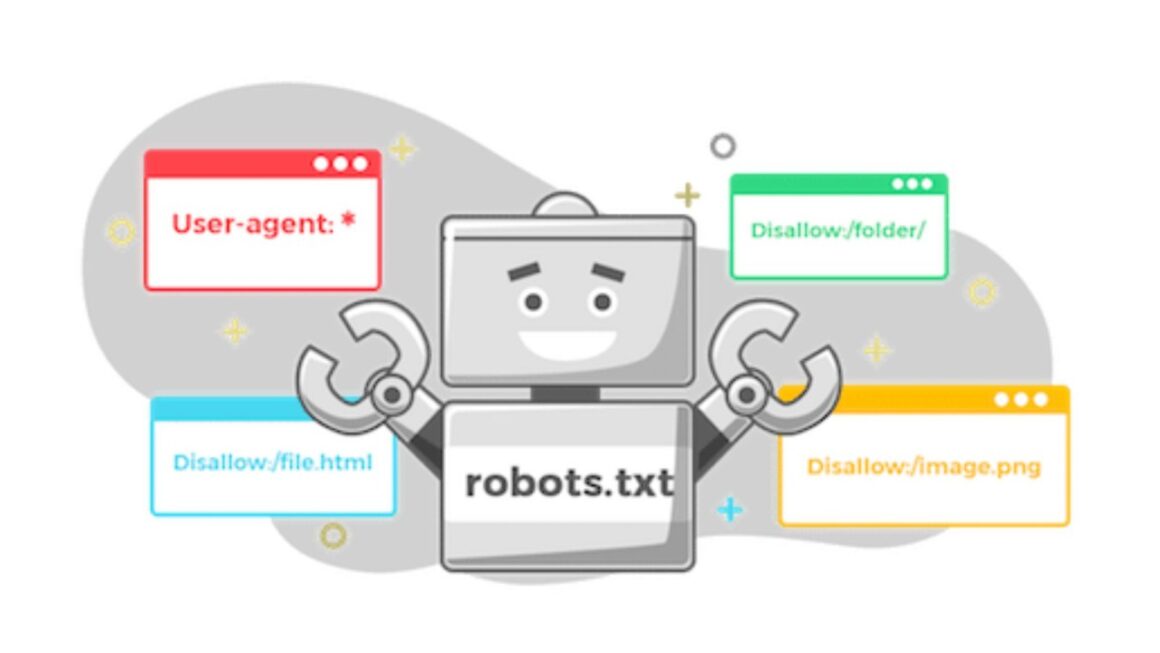

Struktur Dasar Robots.txt

File robots.txt memiliki beberapa aturan dasar yang harus dipahami:

- User-agent: Digunakan untuk menentukan bot mana yang akan diberi instruksi.

- Disallow: Memblokir bot agar tidak mengakses halaman tertentu.

- Allow: Mengizinkan bot untuk mengakses halaman tertentu meskipun berada di dalam direktori yang diblokir.

- Sitemap: Memberikan informasi tentang lokasi sitemap.xml untuk memudahkan proses indexing.

Contoh format dasar robots.txt:

User-agent: *

Disallow: /admin/

Disallow: /wp-login.php

Allow: /blog/

Sitemap: https://www.contohwebsite.com/sitemap.xmlPenjelasan dari contoh di atas:

- Semua bot (ditandai dengan

*) mengikuti aturan ini. - Direktori

/admin/dan halaman login/wp-login.phptidak boleh diakses oleh bot. - Direktori

/blog/tetap boleh diakses. - Sitemap website dicantumkan agar bot dapat menemukan halaman yang perlu diindeks dengan lebih mudah.

Panduan Penerapan Robots.txt yang Benar Sesuai Google

Google memiliki beberapa panduan dalam penggunaan robots.txt agar tidak menghambat proses crawling dan indexing yang seharusnya. Berikut beberapa hal yang perlu diperhatikan:

1. Pastikan File Robots.txt Bisa Diakses

Google harus dapat mengakses file robots.txt agar dapat memahami instruksi yang diberikan. Untuk memastikan file ini dapat diakses, bisa dilakukan pengecekan dengan membuka https://www.namadomain.com/robots.txt pada browser.

2. Jangan Gunakan Robots.txt untuk Memblokir Halaman yang Harus Tetap Aman

Kesalahan umum yang sering terjadi adalah mencoba menggunakan robots.txt untuk menyembunyikan halaman yang berisi data sensitif, seperti halaman login atau informasi pribadi. Ingat, robots.txt hanya memberi instruksi kepada bot agar tidak mengindeks halaman tersebut, tetapi halaman masih dapat diakses secara langsung oleh siapa saja.

Jika ingin menyembunyikan halaman secara aman, lebih baik gunakan metode lain seperti proteksi password atau pengaturan noindex dengan meta tag.

3. Gunakan Perintah Disallow dengan Tepat

Jangan sembarangan menggunakan Disallow: / yang bisa memblokir seluruh website dari pencarian. Pastikan hanya halaman yang benar-benar tidak perlu diindeks yang ditutup menggunakan robots.txt.

Contoh kesalahan:

User-agent: *

Disallow: /Aturan ini akan melarang semua bot untuk mengakses seluruh website, yang berakibat website tidak akan muncul di hasil pencarian sama sekali.

4. Gunakan Robots.txt Bersama dengan Meta Tag Noindex

Jika benar-benar ingin memastikan halaman tidak diindeks oleh mesin pencari, sebaiknya gunakan kombinasi robots.txt dengan meta tag noindex. Robots.txt hanya mencegah crawling, sedangkan noindex mencegah indexing. Cara ini lebih efektif untuk mencegah halaman muncul di pencarian Google.

Contoh meta tag noindex yang bisa ditambahkan ke dalam <head> halaman yang ingin diblokir:

<meta name="robots" content="noindex, nofollow">5. Cantumkan Link ke Sitemap.xml

Menambahkan path sitemap di robots.txt bisa membantu Google menemukan halaman yang ingin diindeks lebih cepat. Ini adalah praktik yang direkomendasikan oleh Google agar proses crawling lebih efisien.

Contoh:

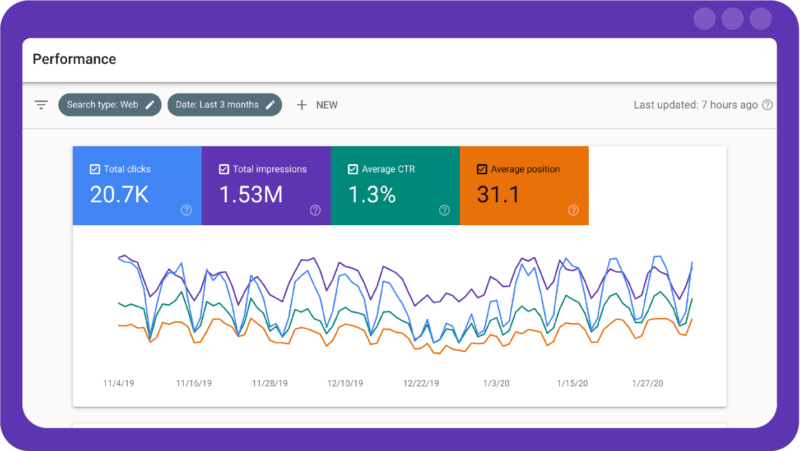

Sitemap: https://www.contohwebsite.com/sitemap.xml6. Gunakan Google Search Console untuk Memeriksa Robots.txt

Setelah menerapkan robots.txt, lakukan pengecekan menggunakan Google Search Console. Di sana terdapat fitur khusus untuk menguji robots.txt dan melihat apakah ada kesalahan yang dapat mempengaruhi performa pencarian website.

7. Hindari Pemblokiran CSS dan JavaScript yang Dibutuhkan

Google menyarankan agar elemen-elemen penting seperti file CSS dan JavaScript tidak diblokir melalui robots.txt. Jika elemen ini diblokir, bisa saja Google tidak dapat merender halaman dengan benar, sehingga berdampak pada peringkat pencarian.

Kesalahan umum yang perlu dihindari:

User-agent: *

Disallow: /wp-content/themes/

Disallow: /wp-includes/Pastikan tidak memblokir direktori yang mengandung file penting yang diperlukan untuk merender halaman dengan baik.

Kesimpulan

Robots.txt adalah alat yang sangat berguna untuk mengontrol bagaimana bot mesin pencari mengakses website. Namun, jika tidak diterapkan dengan benar, bisa berdampak buruk pada performa SEO.

Beberapa poin utama dalam penerapan robots.txt yang benar sesuai dengan panduan Google:

- Pastikan robots.txt bisa diakses.

- Jangan gunakan robots.txt untuk menyembunyikan data sensitif.

- Gunakan perintah Disallow dengan hati-hati.

- Kombinasikan dengan meta tag noindex jika diperlukan.

- Selalu sertakan link ke sitemap.xml.

- Gunakan Google Search Console untuk menguji robots.txt.

- Jangan memblokir CSS dan JavaScript yang dibutuhkan untuk perenderan halaman.

Dengan menerapkan aturan ini, website dapat lebih optimal dalam pencarian Google dan menghindari kesalahan yang bisa menghambat performa SEO.

Bagi Kamu Yang ingin develop Website Maupun Aplikasi Dan membutuhkan Server hosting yang handal, Silahkan bisa mengunjungi halaman jetorbit untuk mendapatkan Promo hosting dan Domain murah, mulai dari 12rb.

Leave a Comment